【SEO优化】网站SEO诊断之robots.txt文件配置误区及详细写法

发布时间:2020-09-17

网站SEO诊断之robots.txt文件配置误区及详细写法,

在网站的基本结构诊断中,IT131已经分别从《》及《》分析过来,接下来我们将从网站的一个特殊文件 robots.txt,来继续探索网站中的基本结构优化。

我们都知道搜索引擎使用 spider 程序自动访问互联网上的网页并获取网页信息。spider 在访问一个网站时,会首先会检查该网站的根域下是否有一个叫做 robots.txt 的纯文本文件,这个文件用于指定 spider 在您网站上的抓取范围。您可以在您的网站中创建一个 robots.txt,在文件中声明该网站中不想被搜索引擎收录的部分或者指定搜索引擎只收录特定的部分。所以这将是我们的第一要素,因为一旦不小心定义错了 robots.txt 文件,网站将可能消失在搜索引擎结果中,以下IT131将会列举需要注意事项,以及 robots.txt 文件的详细写法和 robots 书写例子,同时也收集拓展了一些各大搜索引擎蜘蛛名称。

一、网站 robots.txt 文件注意事项

1、robots.txt 文件必不可少

不论你网站有没有需要禁止搜索引擎抓取的目录或者页面,IT131都建议大家添加一个 robots.txt 文件,因为当搜索蜘蛛发现不存在 robots.txt 文件时,会产生一个 404 错误日志在服务器上,从而增加服务器的负担,因此为站点添加一个 robots.txt 文件还是很重要的。

2、robots.txt 文件命名

可能很多人习惯把因为首字母大写,包括IT131有时候都有这个习惯,所以在 robots.txt 文件命名必须全部小写。

3、robots.txt 文件位置

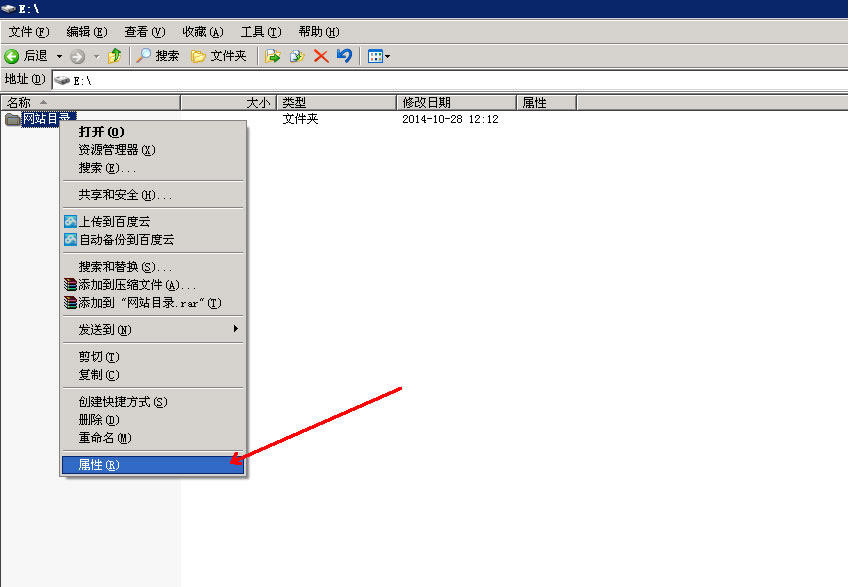

robots.txt 必须放置与站点的根目录下,如果放置在二级目录等位置搜索引擎抓取时均会被忽略。

4、robots 文件书写注意

在书写这些规则语句的时候尤其注意的一点是冒号(:)和( /) 之间要有一个空格符,如果这个空格没有加的话,是不能起到作用的,并且冒号需要是英文半角输入,否则也是无效。

5、robots 规则首字母大写

robots 文件规则的写法中,每一行规则的关键字的首字母都是大写的,如:User-agent、Disallow、Allow、Sitemap

6、robots 规则符号的区别

在屏蔽目录的时候,如果是阻止抓取某目录的话目录名字一定要注意“/”,不带“/”表示的是阻止访问这个目录页面和目录下的页面,而带上“/”则表示进阻止目录下的内容页面,这两点要分清楚。

7、robots 中添加网站地图链接

为了让搜索引擎更快的收录我们的内页,我们一般都会做一个 xml 的百度地图或者谷歌地图,Sitemap: 网站地图,这个命令就可以快速的引导搜索引擎蜘蛛来到你的地图页面对网站内页进行抓取。当网站的死链接过多处理非常麻烦的时候,我们可以利用 robots 来屏蔽这些页面,这样就可以避免网站因为死链接被百度降权。

二、网站 robots.txt 语句详细写法

User-agent: * 这里的*代表的所有的搜索引擎种类,*是一个通配符

Disallow: /admin/ 这里定义是禁止爬寻 admin 目录下面的目录

Disallow: /cgi-bin/*.htm 禁止访问/cgi-bin/目录下的所有以”.htm”为后缀的 URL(包含子目录)。

Disallow: /*?* 禁止访问网站中所有包含问号 (?) 的网址

Disallow: /.jpg$ 禁止抓取网页所有的.jpg 格式的图片

Disallow:/a/b.html 禁止爬取 a 文件夹下面的 b.html 文件。

Allow: /cgi-bin/ 这里定义是允许爬寻 cgi-bin 目录下面的目录

Allow: /tmp 这里定义是允许爬寻 tmp 的整个目录

Allow: .htm$ 仅允许访问以”.htm”为后缀的 URL。

Allow: .gif$ 允许抓取网页和 gif 格式图片

Sitemap: 网站地图 告诉爬虫这个页面是网站地图

三、网站 robots.txt 写法举例

1、禁止所有搜索引擎访问网站的所有部分

User-agent: *

Disallow: /

2、禁止百度索引你的网站

User-agent: Baiduspider

Disallow: /

3、禁止 Google 索引你的网站

User-agent: Googlebot

Disallow: /

4、禁止除 Google 外的一切搜索引擎索引你的网站

User-agent: Googlebot

Disallow:

User-agent: *

Disallow: /

5、禁止除百度外的一切搜索引擎索引你的网站

User-agent: Baiduspider

Disallow:

User-agent: *

Disallow: /

6、禁止蜘蛛访问某个目录

User-agent: *

Disallow: /css/

7、允许访问某个目录中的某些特定网址

User-agent: *

Allow: /admin/html

Allow: /images/index

Disallow: /admin/

Disallow: /images/

四、常见的各大搜索引擎蜘蛛名称

1、百度蜘蛛:Baiduspider,Baiduspider-mobile(抓取 wap)、Baiduspider-image(抓取图片)、Baiduspider-video(抓取视频)、Baiduspider-news(抓取新闻)。注:以上百度蜘蛛目前常见的是 Baiduspider 和 Baiduspider-image 两种。

2、谷歌蜘蛛:Googlebot,这个争议较少,但也有说是 GoogleBot 的。谷歌蜘蛛最新名称为“compatible; Googlebot/2.1;”。还发现了 Googlebot-Mobile,看名字是抓取 wap 内容的。

3、360 蜘蛛:360Spider,它是一个很“勤奋抓爬”的蜘蛛。

4、搜狗蜘蛛:Sogou News Spider,搜狗蜘蛛还包括如下这些:Sogou web spider、Sogou inst spider、Sogou spider2、Sogou blog、Sogou News Spider、Sogou Orion spider,(参考一些网站的 robots 文件,搜狗蜘蛛名称可以用 Sogou 概括,无法验证不知道有没有效)看看最权威的百度的 robots.txt ,http://www.baidu.com/robots.txt 就为 Sogou 搜狗蜘蛛费了不少字节,占了一大块领地。

5、MSN 蜘蛛:MSNBot

6、必应蜘蛛:bingbot ,线上(compatible; bingbot/2.0;)

7、一搜蜘蛛:YisouSpider

8、Alexa 蜘蛛:ia_archiver

9、宜 sou 蜘蛛:EasouSpider

10、即刻蜘蛛:JikeSpider

11、一淘网蜘蛛:EtaoSpider

写在最后:关于网站 robots.txt 文件的优化和设置等其实IT131之前就在泪雪博客发表过,只是都没有非常全面的来分析 robots,包括前些天IT131分享的一个《》,所以IT131才在写这一系列网站 SEO 诊断中单独用最详细的一篇文章来讲解,为的就是一个全面。如果你有耐心慢慢的将本文熟悉,相信对于在网站 SEO 诊断中的 robots.txt 文件优化中会有莫大的收获,至少IT131觉得这肯定是一篇干货文章。当然,如果你还有什么疑问或补充的,欢迎在泪雪博客留言讨论。

- 话题列表

- 推荐阅读

-

- 优质推荐

全站搜索